- Home

- Osservatorio della rete

- Big Science: arriva l’iperconnessione a 200 Gbps

Big Science: arriva l’iperconnessione a 200 Gbps

| Carlo Volpe | Osservatorio della rete

Velocità record per il CNAF, prima sede italiana connessa alla rete GARR alla capacità di 200 Gigabit al secondo

È Bologna la prima città italiana ad avere una sede connessa a 200 Gigabit al secondo. Grazie alla stretta collaborazione con la rete GARR, dallo scorso novembre il CNAF, il centro nazionale di calcolo dell’INFN, può vantare una connessione record alla rete geografica globale.

Non si tratta di uno sfoggio di potenza, alla ricerca di velocità di connessione finora mai provate. Bensì, la risposta ad esigenze molto elevate dei ricercatori che ogni giorno muovono una quantità di dati impressionante. Il collegamento a tali velocità permette infatti al CNAF di essere interconnesso, attraverso la rete GARR, con l’intero sistema mondiale delle reti della ricerca e in particolare con il CERN di Ginevra, dove è prodotta l’enorme mole di dati dell’acceleratore LHC, e con gli altri centri nazionali dove vengono distribuiti e analizzati i dati scientifici.

Per la natura dei dati prodotti dagli esperimenti di fisica delle alte energie, è fondamentale che essi siano distribuiti tra più centri mondiali sia per l’analisi (perché un solo centro non sarebbe sufficiente) sia per ragioni di data preservation, ovvero per garantire una ridondanza ed una affidabilità nell’archiviazione.

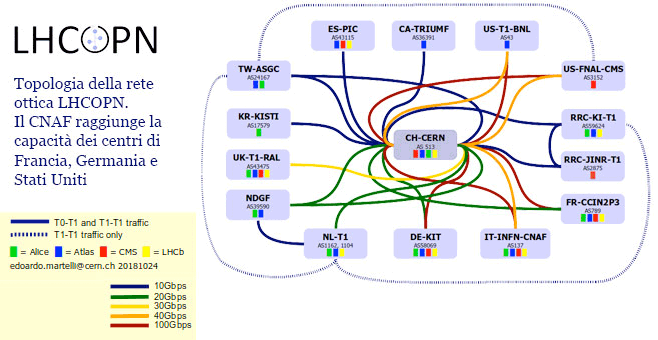

A questo scopo sono state create le reti LHCOPN e LHCONE. La prima è una rete ottica privata con collegamenti dedicati che interconnette 14 centri primari (Tier1) con il CERN e fra di loro; la seconda è una rete più vasta che collega oltre 140 centri tra Tier1 e Tier2 ed è realizzata come una rete privata virtuale sull’infrastruttura esistente a disposizione delle reti della ricerca.

Parliamo di un volume di dati scambiati finora nel 2018 pari a 82 PB, tanti da dover rendere necessario un link a 200 Gbps, ovvero una capacità oltre 200 mila volte superiore alla capacità media di un collegamento Internet in Italia, secondo i dati presentati nel DESI Report 2018.

Il risultato è il coronamento di una serie di interventi di potenziamento, sia per quanto riguarda la rete nazionale GARR sia per la disponibilità di spazio di archiviazione e di potenza di calcolo per l’INFN. Il lavoro sulla rete GARR ha consentito di realizzare una dorsale che raggiunge attualmente la capacità complessiva di circa 3 Tbps, grazie al raddoppio della capacità nei collegamenti dei suoi quattro nodi principali situati nelle città di Milano, Bologna e Roma che, da soli, oggi contano su una capacità complessiva di 800 Gbps.

Allo stesso tempo l’INFN ha potenziato le proprie capacità complessive di calcolo e gestione di Big Data mettendo a disposizione della sua utenza scientifica, e in particolare degli esperimenti a LHC del CERN, più di 60.000 core di potenza computazionale e circa 150 PB di capacità di memorizzazione dei dati sperimentali, divisi tra sistemi ad accesso veloce (dischi) e sistemi di archiviazione lenti (tape).

Come ha dichiarato in occasione dell’inaugurazione del link, il Chief Technical Officer della rete GARR, Massimo Carboni, si tratta di una “risposta importante alla sfida dei Big Data che continuano a crescere nell’ambito degli esperimenti scientifici a livello mondiale. È stato realizzato non solo un collegamento robusto e veloce, ma abbiamo dotato il centro di una infrastruttura resiliente, affidabile e ridondata grazie alla presenza di link di pari capacità su gran parte della nostra dorsale".

Per conoscere più da vicino come sta evolvendo l’infrastruttura a supporto della comunità dei fisici delle altre energie, abbiamo intervistato il responsabile della rete del CNAF, Stefano Zani.

Qual è la principale missione del CNAF?

Il centro di calcolo dell’INFN CNAF ha come prima funzione quella di agire da Tier1 per tutti gli esperimenti di LHC, inoltre rappresenta la principale risorsa di calcolo per buona parte degli altri esperimenti in cui l’INFN è impegnato. Il centro di calcolo si è sviluppato come centro di tipo HTC (High Throughput Computing). Il nostro obiettivo è garantire un’elevata velocità di accesso ai dati in rete locale.

Su quali risorse può contare oggi la comunità della fisica?

Il CNAF mette a disposizione un’importante capacità di elaborazione che oggi è di alcune decine di migliaia di CPU, una grande capacità di storage dell’ordine delle decine di Petabyte su disco e centinaia di Petabyte su nastro. Soprattutto però, abbiamo progettato e realizzato le nostre strutture (Farming, Storage, Network) per rendere queste grandi quantità di dati accessibili a throughput elevati da tutte le CPU a disposizione. Per raggiungere questo scopo, è necessario costruire le Storage Area Network in modo da riuscire a sfruttare le performance dei controller e dei dischi passando negli anni da Fiber Channel ad Infiniband.

Gli ultimi server che costituiscono il “layer" di frontend agli apparati di storage, sono collegati alla rete con 2 interfacce 100 Gigabit Ethernet ed il “core" della rete è costituito da due apparati caratterizzati da un throughput teorico di più di 100 Terabit per secondo.

Perché questo nuovo collegamento a 200 Gbps è così importante?

Per noi è un risultato straordinario perché permette al CNAF di sfruttare appieno le proprie risorse di calcolo e storage in ambito internazionale, favorendo così lo sviluppo di modelli di calcolo distribuito ad alte prestazioni su scala globale. Questa grande ampiezza di banda ci consente un’integrazione sempre più stretta con il CERN e ci pone, in termini di connettività, allo stesso livello dei più importanti centri di calcolo scientifico americani, come il Fermilab e il Brookhaven National Laboratory.

Considerato che i dati degli esperimenti vengono distribuiti in tutto il mondo, ora il ruolo dell’Italia può cambiare ed assumere un maggior peso?

Avere a disposizione una maggiore capacità di banda e un elevato numero di risorse storage significa che da noi passerà anche una quantità di dati più elevata, perché con un certo grado di automazione il percorso dei dati segue la disponibilità delle risorse e il livello delle prestazioni garantite.

L’evoluzione dei modelli di calcolo degli esperimenti prevede, infatti, oltre alla mole di dati proveniente direttamente dal CERN, anche consistenti flussi di dati fra i 14 Tier1 internazionali di LHC collegati dalla rete LHCOPN. Inoltre, ci sono elevati scambi di dati fra i Tier1 ed i Tier2 (che sono più di 140) organizzati nella rete LHCONE. La rete GARR oltre al Tier1 del CNAF, collega alla rete LHCONE anche altri 9 Tier2 ospitati da altre sedi INFN tutti alla velocità di 10 Gbps o di 2x10 Gbps in base alle necessità.

INFN e GARR, inoltre, partecipano insieme ai gruppi tecnici internazionali di evoluzione delle reti LHCOPN e LHCONE. Questa stretta collaborazione ha consentito di fare crescere la connettività geografica del CNAF fino al valore attuale.

Si prevede inoltre nei prossimi mesi di affiancare un ulteriore link a 100 Gbps verso il CERN soprattutto per offrire una migliore ridondanza che oggi è comunque garantita da un aggregato di 4 linee a 10 Gbps.

Quello di oggi si associa ad un altro record raggiunto nella scorsa primavera, con l’interconnessione con il data centre del Cineca a 1,2 Terabit al secondo…

Esatto. Mentre oggi annunciamo un link su scala geografica globale, ad aprile abbiamo realizzato un collegamento, basato esclusivamente sulla trasmissione ottica, tra due data centre per poterli utilizzare come se fossero nello stesso posto e sulla stessa rete locale.

A Bologna, infatti, oltre al Tier1 del CNAF, risiede anche il Cineca che è il più grande centro scientifico di High Performance Computing in Italia ed ospita uno dei più grandi supercomputer al mondo (Marconi è al 19° posto nella classifica TOP500 di novembre). Con lo scopo di favorire i progetti di collaborazione fra INFN e Cineca, abbiamo realizzato una estensione della rete locale del Tier1 fino al centro di calcolo del Cineca distante poco meno di 20 km dalla sede del CNAF. L’obiettivo era di potere istanziare e gestire risorse di calcolo situate al Cineca esattamente come se si trovassero all’interno del Tier1, mantenendo la stessa banda di accesso ai dati ed utilizzando gli stessi strumenti di gestione utilizzati localmente.

GARR ha supportato fin dall’inizio questo progetto di Data Centre Interconnection ad altissime prestazioni e, grazie ad una fibra ottica acquisita dalla rete regionale Lepida ed all’utilizzo di una coppia di transponder di ultima generazione prodotti da Infinera (Cloud Express 2), è stato realizzato questo link della capacità di 1,2 Terabit al secondo oggi sfruttato a 500 Gbps. Questa tecnologia, consente sulla stessa coppia di fibre, di potere scalare fino ad una banda di 27,6 Terabit al secondo fino ad un massimo di circa 100 km di distanza.

E per il futuro?

Le enormi quantità di dati prodotte principalmente da LHC nei prossimi anni, imporranno di spingere ancora più all’estremo le tecnologie di interconnessione fra i centri. Il modello verso il quale sembra orientarsi il mondo della fisica delle alte energie è chiamato “Data Lake", ovvero un data storage distribuito su scala geografica dove i dati possano essere “pescati" indipendentemente dal posto in cui verranno poi elaborati. Il modello prevede di costruire “pochi" gruppi di Storage Data Center di grandi dimensioni geograficamente distribuiti gestiti ed acceduti come singole entità. Ovviamente, le tecnologie per l’interconnessione di questi grandi data centre dovrà essere dell’ordine di grandezza dei Terabit e questo rappresenta una sfida importante che GARR ed INFN affronteranno insieme.

SD-WAN Integration: Intervento di Stefano Zani al Workshop GARR 2018

Topologia della rete ottica LHCOPN. Il CNAF raggiunge la capacità dei centri di Francia, Germania e Stati Uniti

Dai un voto da 1 a 5, ne terremo conto per scrivere i prossimi articoli.

Voto attuale:

Ultimi articoli in rubrica

-

di Carlo Volpe

-

di Carmine Piccolo, Mario Maiorino

-

di Carlo Volpe

-

di Elis Bertazzon

-

di Carlo Volpe

Telegram

Telegram