Verso un modello linguistico italiano di grandi dimensioni?

| Elis Bertazzon | Storie

Sfide e opportunità dell’AI generativa

Alla recente Conferenza GARR 2024, un panel di esperti ha esplorato le prospettive e le sfide legate allo sviluppo di modelli di intelligenza artificiale generativa in Italia.

Moderato dal professor Davide Bacciu dell’Università di Pisa, il panel ha riunito ricercatori e ricercatrici provenienti da diverse università italiane: la professoressa Viviana Patti dell’Università di Torino, il dottor Lorenzo Baraldi dell’Università di Modena e Reggio Emilia, e la dott.ssa Lucia Siciliani dell’Università di Bari. Insieme, hanno discusso le potenzialità e le implicazioni dello sviluppo di un modello linguistico di grandi dimensioni (LLM) “Made in Italy”....ma che significa? Vediamolo insieme.

AI e AI generativa: come funzionano?

L’intelligenza artificiale (o AI) crea sistemi capaci di svolgere compiti normalmente attribuibili all’intelligenza umana, come il riconoscimento del parlato o la comprensione del linguaggio naturale. Funziona per lo più attraverso algoritmi e modelli che apprendono dai dati e che migliorano con l’esperienza. L’AI generativa è una specifica branca dell’intelligenza artificiale che si distingue per la sua capacità di creare contenuti nuovi. Nell’immaginario dei più, l’AI generativa è associata a Chat-GPT e alla capacità di generare risposte testuali, verosimili, se non esatte, interagendo naturalmente con le persone.

Un esempio di AI generativa sono i large language model (LLM) o modelli linguistici di grandi dimensioni, come GPT (Generative Pre-trained Transformer), che sono addestrati su enormi quantità di dati testuali per comprendere e generare linguaggio naturale.

Non un modello, ma un sistema nazionale di AI generativa

Questi modelli si basano su due fasi principali: l’addestramento (o pre-training) e l’affinamento (o fine-tuning). Durante l’addestramento, i modelli imparano le strutture linguistiche generali attraverso l’esposizione a grandi quantità di testi. Successivamente, il fine-tuning ottimizza i modelli per compiti specifici, come la conversazione o la traduzione, spesso con l’aiuto di feedback umano, nel cosiddetto apprendimento con rinforzo.

L’importanza dei dati e i modelli multimodali

È come se il cuore di un modello LLM fosse rappresentato dall’addestramento, che spesso avviene con testi multilingue, in modo da raggiungere un’ottima conoscenza generale. Solo in un secondo momento il modello viene affinato per rispondere ad un compito specifico. La quantità e il tipo di dati su cui avviene il pre-training è determinante per questa tecnologia e comporta delle implicazioni importanti che vanno dalla trasparenza dei dati utilizzati alla presenza di preconcetti e stereotipi (bias) che possono essere inavvertitamente ripetuti e rinforzati. Per dirla con le parole della professoressa Patti “i dati non sono mai veramente grezzi, ossia neutri: essi sono condizionati da molti fattori, anche dalle pratiche stesse di raccolta”.

I modelli generativi, però, non si limitano al testo, ma possono essere multimodali. Questi sistemi avanzati sono in grado di elaborare e generare contenuti a partire da diverse forme di input, incluse le immagini e i filmati. Nel concreto, un modello multimodale può analizzare un’immagine, descriverne il contenuto in parole, e rispondere a domande su ciò che è ritratto. Un esempio concreto è DALL-E, che può creare immagini a partire da descrizioni testuali, o CLIP, che può comprendere e classificare immagini basandosi su descrizioni testuali.

Un modello italiano: molto più di una questione di lingua

Cosa significa avere un “modello nazionale” dell’intelligenza artificiale generativa? Rispondere non è affatto banale e nel farlo potrebbe essere utile confrontarci con le esperienze portate dai partecipanti alla tavola rotonda.

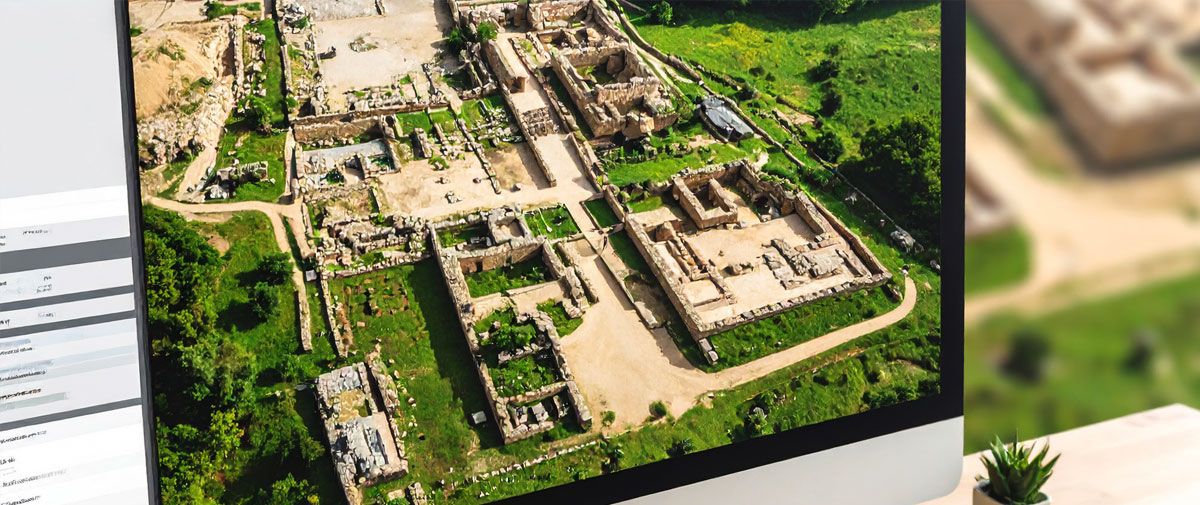

Prima di tutto abbiamo visto che gli LLM sono addestrati su basi multilingue, sebbene i dati in inglese abbiano una forte predominanza. Si potrebbe pensare che sia sufficiente basarsi su delle traduzioni dei dati in italiano, ma gli esperimenti condotti dai ricercatori, come Lucia Siciliani dell’Università di Bari, dimostrano che l’uso di testi in italiano tradotto produce risposte non soddisfacenti, con errori di comprensione. Questo perché una lingua non è soltanto un insieme di grammatica e lessico, ma porta con sé aspetti socioculturali e storici, oltre a numerose varianti geografiche. Per questo, per dirla con le parole del professor Bacciu, “un modello nazionale non può essere solo un modello madrelingua italiano, perché in un mondo multiculturale e multilingue è importante che l’italiano sia incluso all’interno di un modello che sia in grado di parlare tutte le lingue del mondo. Ciò che è davvero importante è che questo modello porti con sé la conoscenza, i fatti, gli aspetti culturali dell’orizzonte nazionale. E questo ha un impatto sia sull’aspetto testuale, per esempio, ma anche sull’aspetto visivo”.

Un esempio viene dal professor Baraldi: un modello sviluppato presso l’Università di Modena e Reggio Emilia capace di analizzare l’immagine di una Ferrari e fornire commenti dettagliati sul tipo di auto, il modello specifico e il produttore. Uno strumento di questo tipo potrebbe rappresentare un valido strumento per valorizzare e promuovere le eccellenze nazionali, andando oltre la semplice elaborazione linguistica.

Ma c’è di più. L’eccellenza nazionale si trova anche nella ricerca e nelle competenze tecnologiche necessarie per sviluppare questi strumenti. Più che costruire un modello nazionale di intelligenza artificiale è necessario costruire un sistema che fornisca ulteriori capacità tecniche e di sviluppo al paese.

Per il progetto Lamantino, l’accesso al supercomputer Leonardo ha rappresentato un momento di svolta perché ha fornito le risorse computazionali che in ateneo non erano disponibili

Un sistema nazionale: i pilastri fondamentali

Questo sistema richiede un approccio collaborativo e poggia su dei pilastri fondamentali: capacità di calcolo e storage, per l’elaborazione e la memorizzazione dei dati, connessioni ad altissime velocità e un modello aperto e trasparente per la raccolta e la gestione dei dati.

Come dice Bacciu, “affinché un modello sia utile al paese è necessario che questo sia trasparente dalla sua concezione al suo utilizzo”. Questo riguarda i dati utilizzati, il codice usato per crearlo, tutti i singoli passaggi compiuti per realizzarlo, e infine il suo rilascio al pubblico: è importante che ci sia un’architettura aperta per poter mettere a fattor comune i dati.

C’è poi l’aspetto computazionale: stiamo parlando di modelli che hanno miliardi, decine di miliardi di parametri, il che si traduce nella necessità di avere accesso a enormi risorse di calcolo e di memorizzazione che non sono disponibili nelle singole università. Per questo motivo, c’è bisogno non solo di infrastrutture legate ai dati, ma anche di infrastrutture legate al calcolo, alla memorizzazione e a una rete veloce, come GARR, che permetta lo scambio e la collaborazione tra più modelli generativi. In questo contesto, la capillarità su scala nazionale della rete della ricerca italiana rappresenta una grande risorsa per mettere tutti gli atenei in condizione di raggiungere le infrastrutture di supercalcolo, come ad esempio Leonardo, e di mettere a rete le proprie risorse di calcolo e storage.

Il futuro è interconnesso

Una delle prospettive più interessanti emerse durante il panel riguarda il futuro dell’AI generativa in Italia. I relatori hanno delineato una visione in cui, anziché puntare su un singolo modello monolitico, si possa sviluppare una rete di modelli interconnessi, ciascuno sviluppato da diversi attori del panorama accademico e industriale italiano e interconnessi da un’infrastruttura di rete avanzata.

Questo approccio collaborativo potrebbe portare a significativi miglioramenti nella qualità delle risposte generate, ad una maggiore diversità nei contenuti prodotti, ad un ecosistema di AI più robusto e flessibile, e, aspetto non meno importante, alla capacità di mantenere nel paese le competenze tecnologiche e scientifiche legate a questo tipo di tecnologia, così determinante per il futuro. In questo modo si verrebbe a creare una nuova comunità, trasversale ai differenti ambiti scientifici, in grado di parlare la lingua comune dei concetti e delle tecnologie legate alla AI generativa.

I protagonisti del panel

Viviana Patti dell’Università di Torino ha spiegato i modelli di generazione linguistica come GPT, evidenziando la recente accelerazione e l’importanza di raccogliere risorse in lingua italiana per creare modelli trasparenti e aperti.

Lorenzo Baraldi dell’Università di Modena e Reggio Emilia ha parlato dei modelli LLM multimodali e del progetto PNRR MORE, che sviluppa un LLM italiano utilizzando risorse testuali e non, sfruttando tecnologie come CINECA e Leonardo.

Lucia Siciliani dell’Università di Bari ha affrontato le sfide computazionali dei modelli fondazionali, descrivendo l’uso di Leonardo nell’addestramento di un modello in lingua italiana. Ha sottolineato poi l’importanza dei temi etici nei programmi di formazione sull’AI dei ricercatori e non solo.